LLM을 활용한 실전 AI 애플리케이션 개발

- 허정준

트랜스포머 아키텍처를 사용하는 여러 모델들의 구현 방식에 차이가 있어 어려움 발생

=>

허깅페이스가 일관된 트랜스포머 라이브러리 제공

pip install transformers==4.40.1 datasets==2.19.0 huggingface_hub==0.23.0 -qqq

-qqq 없는 게 난 더 좋은 듯

🔬허깅페이스 트랜스포머란

허깅페이스 기능

transformers 라이브러리

- 트랜스포머 모델

- 토크나이저

datasets 라이브러리

- 데이터셋

다양한 모델을 거의 동일한 인터페이스로 사용 가능하게 함!

BERT/GPT-2 예시

rom transformers import AutoTokenizer, AutoModel

text = "What is Huggingface Transformers?"

# BERT 모델 활용

bert_model = AutoModel.from_pretrained("bert-base-uncased")

bert_tokenizer = AutoTokenizer.from_pretrained('bert-base-uncased')

encoded_input = bert_tokenizer(text, return_tensors='pt')

bert_output = bert_model(**encoded_input)

# GPT-2 모델 활용

gpt_model = AutoModel.from_pretrained('gpt2')

gpt_tokenizer = AutoTokenizer.from_pretrained('gpt2')

encoded_input = gpt_tokenizer(text, return_tensors='pt')

gpt_output = gpt_model(**encoded_input)모델 불러오고, 토크나이저 불러오고, 인풋 받아서 토크나이저 써서 모델에 보내서 응답 받기

🔬허깅페이스 허브 탐색하기

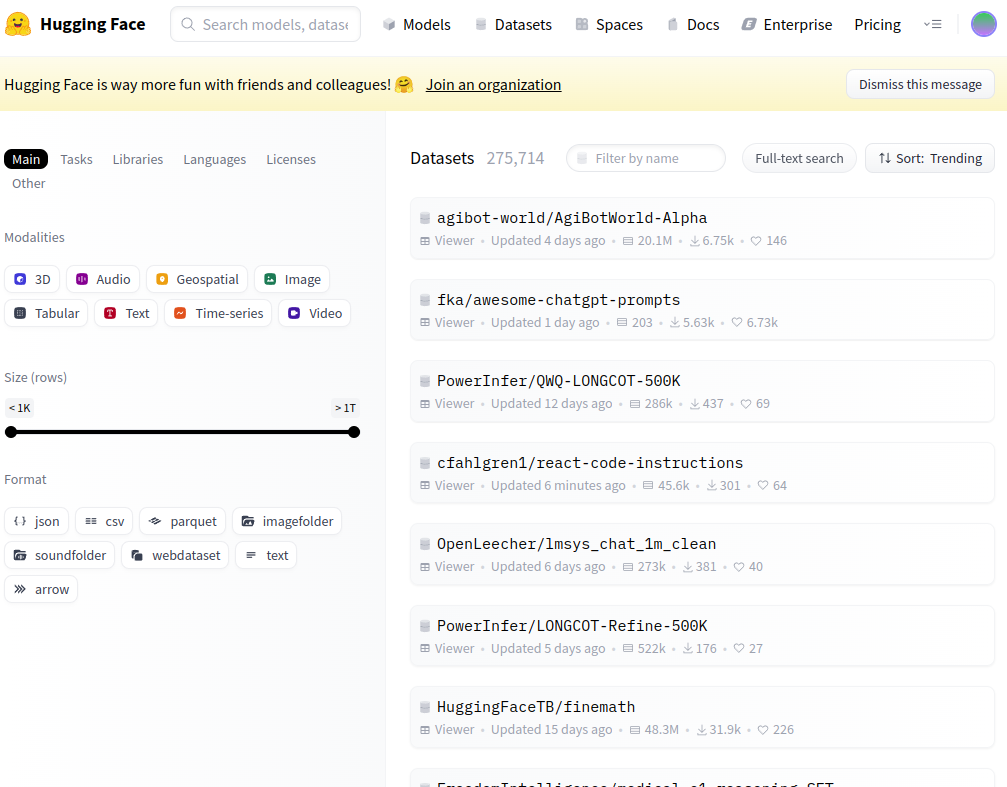

허깅페이스 허브 : 다양한 모델, 데이터셋 보고 사용 가능한 플랫폼

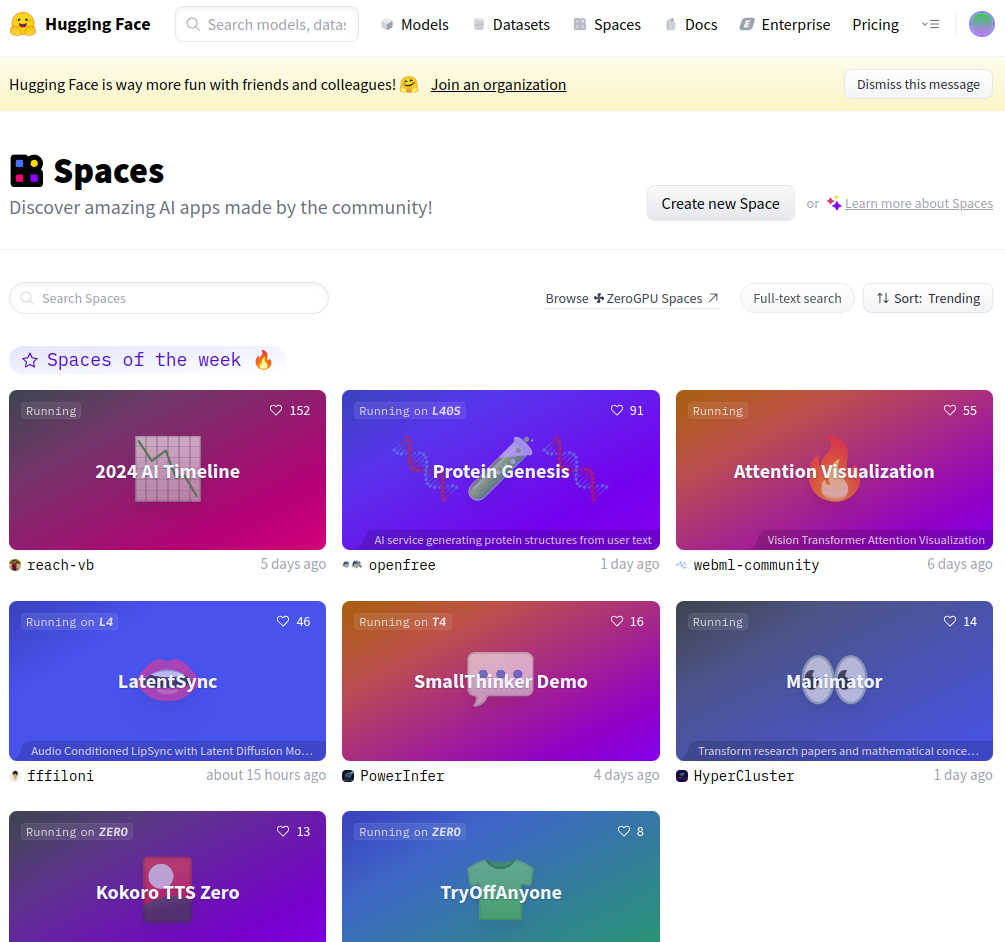

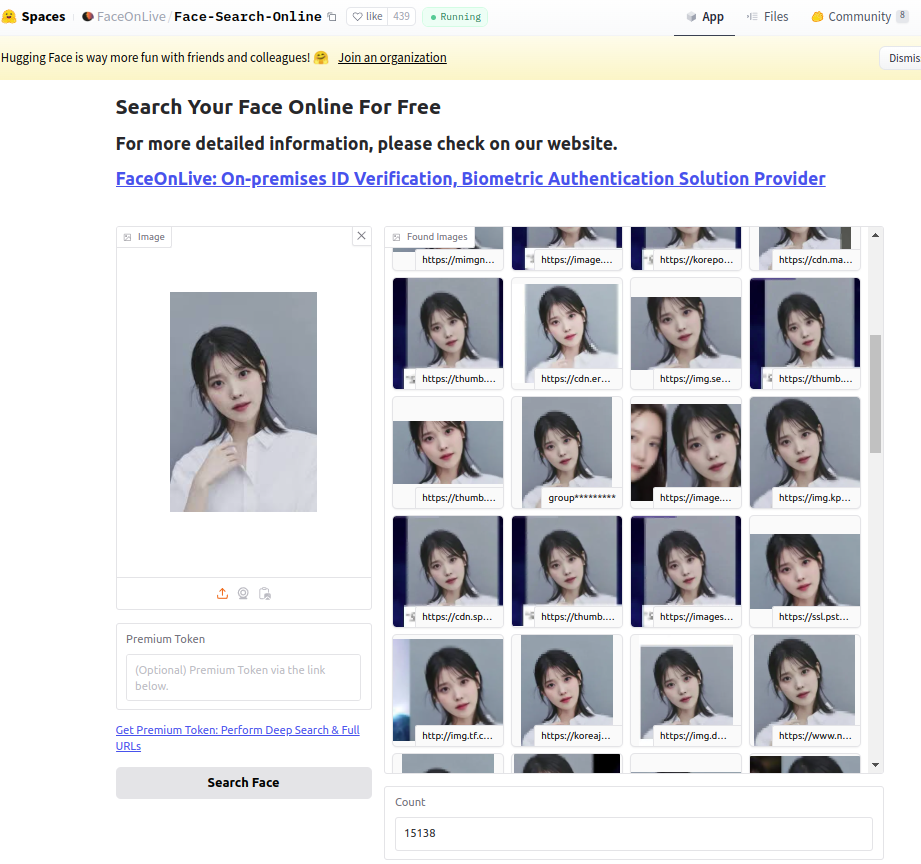

스페이스 : 자신의 모델 데모를 제공하고 다른 사람의 모델 사용 가능

모델 허브

다양한 카테고리별 모델 확인 가능

모델 다운로드 수, API 사용 가능

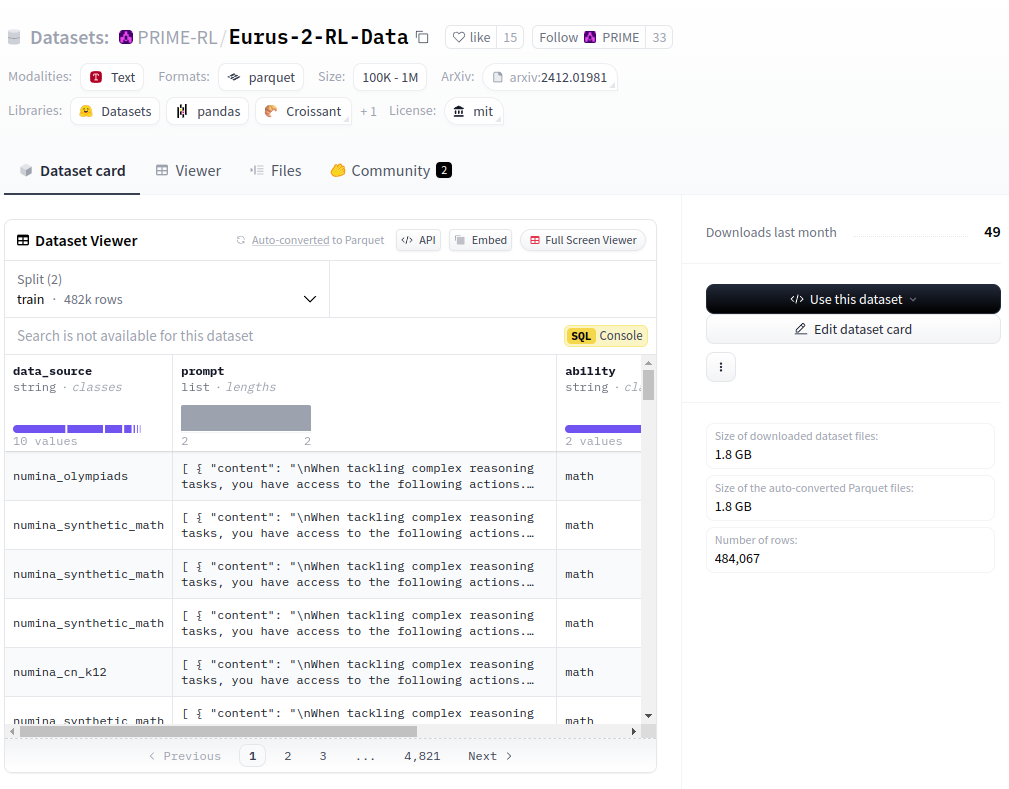

데이터셋 허브

다양한 유형의 데이터

서브셋(유형) 확인

스페이스

모델 데모를 공개하고 사용할 수 있음

리더보드

모델의 크기와 성능 한눈에 비교

영어 학습 llm 리더보드

Open LLM Leaderboard - a Hugging Face Space by open-llm-leaderboard

huggingface.co

업스테이지 운영 한국어 학습 LLM 리더보드

Open Ko-LLM Leaderboard - a Hugging Face Space by upstage

huggingface.co

- Ko-XX : 벤치마크 데이터셋

- Average : 벤치마크 성능 평균

- 기타 여러 필터값 조절 가능

'🤖 AI > AI' 카테고리의 다른 글

| 🔬트랜스포머 모델을 다루기 위한 허깅페이스 트랜스포머 라이브러리 3 (0) | 2025.01.07 |

|---|---|

| 🔬트랜스포머 모델을 다루기 위한 허깅페이스 트랜스포머 라이브러리 2 (0) | 2025.01.07 |

| 🔬LLM의 중추, 트랜스포머 아키텍처 살펴보기 1 (0) | 2025.01.06 |

| Prompt caching : input_cached_tokens 🪙 (0) | 2025.01.03 |

| 🥶 OpenAI_endpoints_chat 매개변수 탐구 (1) | 2025.01.03 |