뇽뇽뇽

✳️ 논문 읽기

Attention Is All You Need

https://proceedings.neurips.cc/paper/2017/file/3f5ee243547dee91fbd053c1c4a845aa-Paper.pdf

사실 뒤로 갈수록 힘 빠짐..

✳️ 더 공부 : 유튜브 강의

나동빈씨 짱

강의 잘 하심

트랜스포머 이전 전통적 임베딩

- 원 핫 인코딩

- 각각의 레이어

트랜스포머

- RNN을 사용하지 않으려면 별도 위치 정보를 알려줘야 함

- Positional Encoding 필요

- 각각의 토큰에 대해 연관된 확률 계산 가능

- 각각의 레이어는 이 인코더 에 마지막 레이어에서 나오게 된 출력값을 입력으로 받는 것

- 하나의 레이어에서 어텐션 두 번

- 셀프 어텐션 : 각각의 단어들이 서로가 서로에게 어떠한 가중치를 가진 인자를 구하도록 만들 (출력되고 있는 문장에 대한 전반적인 표현을 학습)

- 인코더에 대한 정보를 어텐션 할 수 있도록 ( 출력 단어가 인코딩 된 출력 정보를 받아와 사용할 수 있도록 / 각각의 출력되고 있는 단어가 소스 문장에서의 어떤 단어와 연관성이 있는지를 구해 주기)

RNN ㄴㄴ

순차적으로 넣지 않고 병렬적으로 한번에 넣기 가능 ( 연산속도 개선)

멀티 헤드 어텐션이란?

• 쿼리(Query, Q)

• 현재 집중하고 싶은 정보를 나타내는 벡터

• 주어진 입력에 대해 “어디를 봐야 하는지”를 결정

• 예: 번역할 문장에서 현재 번역 중인 단어

• 키(Key, K)

• 모든 후보 정보를 나타내는 벡터

• Query와 비교하여 얼마나 관련성이 있는지 판단하는 기준

• 예: 원본 문장의 모든 단어 벡터

• 밸류(Value, V)

• 실제 가져올 정보를 담고 있는 벡터

• Query가 Key와 얼마나 유사한지에 따라 가중치를 받아 최종적으로 결합됨

• 예: 원본 문장의 단어 의미 정보

예제: 영어 → 한국어 번역

Transformer 기반 기계 번역에서 “I love cats” → “나는 고양이를 좋아해” 를 번역한다고 가정

1. 쿼리(Query, Q):

• 현재 번역 중인 단어, 예를 들어 “좋아해”

• “좋아해”라는 단어를 예측하기 위해 어떤 원문 단어를 참고해야 하는지 결정해야 함.

2. 키(Key, K):

• 원문 문장의 모든 단어 ([“I”, “love”, “cats”])의 벡터 표현

• Query (“좋아해”)와 Key ([“I”, “love”, “cats”])를 비교하여 어떤 단어가 중요한지 판단.

3. 밸류(Value, V):

• 원문 문장의 단어 벡터 ([“I”, “love”, “cats”])에서 의미 정보를 포함한 값

• Query가 높은 점수를 준 Key의 Value를 최종적으로 조합하여 “좋아해”를 생성.

쿼리가 각각의 키 값에 대해 에너지값을 구할 수 있음

소프트맥스(Softmax) 함수 : 다중 클래스 분류 문제에서 출력 확률을 정규화하는 데 사용되는 함수

Attention Anergies 구하 수 있슴

입= 출력 차원 동일

mask matrix

어텐션 세 개

- 인코더 셀프 어텐션

각각의 단어가 서로에게 어떠한 연관성을 가지는 질 어떤 천을 통해서 구하도록 만들 - masked decoder self attention

디코더 최종 출력 시 : 전부 참고 하도록 만들지 않고 앞쪽에 등장했던 단어들만 참고할 수 있도록 - 인코더 디코더 어텐션

쿼리가 디코더에 있고 각각의 키/ 밸류는 인코더에 있는 상황을 의미하는 것

스코어로 가시적으로 확인 가능!

ㅇㅋㅇㅋ

✳️ 더 공부 : 교재

'Club|Project > Euron | AI,데이터분석 학회' 카테고리의 다른 글

| 🧠 ResNet 잔차 신경망 (0) | 2025.03.17 |

|---|---|

| ✳️ [Attention Is All You Need] 논문 코드 구현 / ppt제작 (0) | 2025.03.16 |

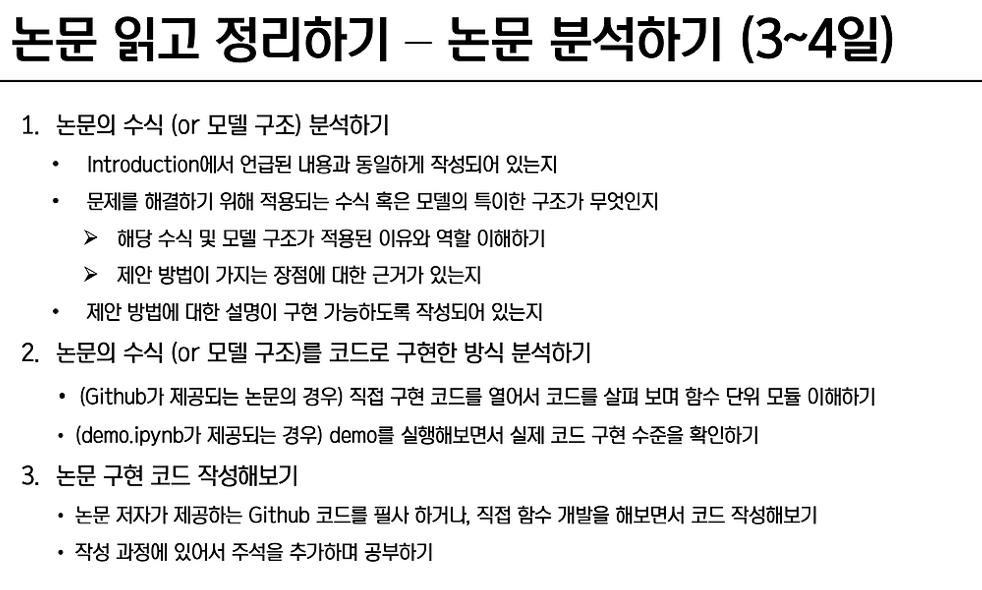

| ✳️ AI 논문 리뷰 템플릿 / 논문 고르는 법 / 논문 읽는 법 (0) | 2025.03.10 |

| ✳️ [Deep residual learning for image recognition] 논문 리뷰 (0) | 2025.03.06 |

| ✳️ Euron OT ✳️ (0) | 2025.03.04 |